AI Security: Künstliche Intelligenz in der Cybersicherheit

Schutzmechanismen für die digitale Zukunft

Die Cyber-Kriminalität nimmt nicht nur an Häufigkeit, sondern auch an Komplexität zu - gleichzeitig ist die Integration von Künstlicher Intelligenz (KI) für Unternehmen unverzichtbar geworden. Moderne IT-Sicherheitslösungen müssen deshalb auch gezielt darauf ausgerichtet sein, Unternehmen vor KI-gestützten Cyber-Attacken zu schützen.

Erfahren Sie jetzt, was KI-Sicherheit bedeutet und wie Sie sicher in die KI-Zukunft kommen!

Was ist AI Security?

Im Wettlauf um die Vorteile, die sich aus dem Einsatz von KI-Systemen ergeben, wird deren Sicherheit immer wichtiger. Unternehmen und Regierungen müssen sicherstellen, dass sie robuste KI-Sicherheitsstrategien entwickeln, um böswillige Angriffe mittels KI zu verhindern und gleichzeitig ihre eigenen KI-gestützten Abwehrmaßnahmen zu etablieren. Andererseits müssen durch die Nutzung von speziellen Technologien, Tools und Frameworks die KI-Systeme selbst abgesichert und vor potenziellen Angriffen geschützt werden.

Wichtige Aspekte einer sicheren KI sind Manipulationssicherheit, Datensicherheit und Systemintegrität. Das Bundesamt für Sicherheit in der Informationstechnik (BSI) empfiehlt daher, der Cybersicherheit bzw. der Cyber Security höchste Priorität einzuräumen. Laut BSI wird es entscheidend sein, die Geschwindigkeit und den Umfang der Abwehrmaßnahmen zu erhöhen. Dazu gehören der Aufbau einer resilienten IT-Infrastruktur, die Verbesserung der Angriffserkennung, die Stärkung der Prävention von Social Engineering (z.B. Awareness-Schulungen, Multi-Faktor-Authentifizierung, Zero-Trust-Architektur) sowie die Nutzung der generellen Vorteile von KI für die Abwehr (z.B. Bedrohungs- und Schwachstellenerkennung).

Buch-Empfehlung

Künstliche Intelligenz und Wir

Stand, Nutzung und Herausforderungen der KI

Erhalten Sie einen umfassenden Überblick über den aktuellen Stand der Technikentwicklung und die zukünftigen Möglichkeiten der Künstlichen Intelligenz (KI). Experten aus verschiedenen Disziplinen beleuchten die vielfältigen Aspekte der KI, von technischen Grundlagen über ethische Fragestellungen bis hin zu gesellschaftlichen und wirtschaftlichen Auswirkungen.

Zu den Herausgebern gehören der Wirtschaftswissenschaftler Frank Schmiedchen, der seit 2017 die Studiengruppe Technikfolgenabschätzung der Digitalisierung der Vereinigung Deutscher Wissenschaftler leitet, der ehemalige Vizepräsident der Gesellschaft für Informatik Alexander von Gernler, der Abteilungsleiter Research und Innovation der genua GmbH ist, die Wirtschaftsinformatikerin Martina Hafner, die bei der genua GmbH als Innovationsmanagerin arbeitet, und Klaus Peter Kratzer, der Professor für Informatik an der Technischen Hochschule Ulm war.

Absicherung vor KI-Angriffen

KI-gestützte Produkte vor KI-Angriffen schützen

KI birgt erhebliche Risiken für die IT-Sicherheit, da sie nicht nur potenziell Schwachstellen in bestehenden Systemen schafft, sondern auch selbst Ziel und Werkzeug von Angriffen werden kann. Für den öffentlichen Sektor und kritische Infrastrukturen ist das Risiko von Cyber-Bedrohungen besonders hoch. Um Produkte mit KI vor Angriffen – auch durch andere KI – zu schützen, sollten Unternehmen mehrere strategische Maßnahmen ergreifen. Insbesondere das Thema Datenschutz gewinnt zunehmend an Relevanz. Da KI große Datenmengen analysiert, besteht die Gefahr, dass sensible Informationen kompromittiert werden. Unternehmen müssen daher sicherstellen, dass sie die Datenschutzbestimmungen einhalten und geeignete Sicherheitsvorkehrungen treffen, um Datenmissbrauch zu verhindern.

Komplexe Social Engineering-Angriffe abwehren

Sie zielen darauf ab, durch Manipulation menschlichen Verhaltens an vertrauliche Informationen oder Zugänge zu gelangen. Durch Schulung und Sensibilisierung der Mitarbeiter, strenge Sicherheitsrichtlinien für Zugriffsrechte, Passwortrichtlinien und Sicherheitsprotokolle, den Einsatz von Anomalieerkennung und Zero Trust sowie klare Reaktionsmechanismen können Unternehmen das Risiko solcher Angriffe erheblich reduzieren.

Erkennen und Abwehren von Prompt Injection und Manipulation

Ein zentraler Punkt ist das Risiko von Prompt Injections. Bei einer Prompt Injection wird eine KI, insbesondere ein Sprachmodell, durch manipulierte Eingaben (Prompts) unwissentlich dazu gebracht, die Absichten des Angreifers auszuführen. Prompt Injections sind besonders relevant für KI-basierte Anwendungen wie Chatbots, KI-Agenten oder Sprachmodelle, die auf Benutzereingaben reagieren. Die Ergebnisse eines erfolgreichen Prompt-Injection-Angriffs können sehr unterschiedlich sein. Sie reichen von der Erlangung sensibler Informationen bis hin zur Beeinflussung kritischer Entscheidungsprozesse unter dem Deckmantel des normalen Betriebs. Schutzmaßnahmen umfassen strenge Eingabevalidierung und Filtermechanismen, die verhindern, dass unsichere oder manipulierte Eingaben verarbeitet werden. Regelmäßige Tests und das Monitoring von Modellausgaben helfen ebenfalls, solche Angriffe frühzeitig zu erkennen.

IT-Sicherheit für KI-Agenten

Da KI-Agenten zunehmend autonom agieren, können Fehlfunktionen oder Missverständnisse bei der Datenanalyse zu falschen Sicherheitsmaßnahmen führen. Beispielsweise könnte einem legitimen Nutzer fälschlicherweise der Zugriff entzogen oder ein Angriff übersehen werden. Durch eine Kombination aus technischer Robustheit, menschlicher Überwachung und kontinuierlicher Verbesserung (Audits, Updates und Patches) können Unternehmen sicherstellen, dass KI-Agenten zuverlässig arbeiten und potenzielle Risiken so minimiert werden.

Einsatz von Überwachungs- und Anomalieerkennungssystemen

Ähnlich wie mit dem sogenannten maschinellen Lernen, kurz ML, Anomalien erkannt werden können, können Cyberkriminelle mit KI-gestützten Systemen Netzwerke scannen und systematisch nach Schwachstellen suchen, über die dann getarnte Schadsoftware eingeschleust und Angriffe auf (andere KI-)Systeme durchgeführt werden können. KI-gestützte Systeme zur Anomalieerkennung können helfen, verdächtige Aktivitäten oder unerwartetes Verhalten innerhalb der KI-Anwendung oder -Infrastruktur zu erkennen. Sie identifizieren ungewöhnliche Muster, die auf einen potenziellen Angriff hindeuten könnten, und erhöhen die Reaktionsfähigkeit auf mögliche Angriffe.

Modelle gegen Datenmanipulation absichern

KI-Modelle, die mit sensiblen oder kritischen Daten trainiert werden, müssen vor Data-Poisoning-Angriffen geschützt werden. Dabei werden während des Trainings manipulierte Daten eingeschleust, um die Leistung des Modells zu beeinträchtigen. Um die Integrität des Modells zu gewährleisten, müssen die Trainingsdaten regelmäßig überprüft und auf ihre Integrität überwacht werden. Weiterhin dürfen nur vertrauenswürdige Datenquellen verwendet werden.

Adversarial Robustness und Testen der Modelle

Angreifer können sogenannte Adversarial Attacks einsetzen, bei denen minimal veränderte Eingabedaten KI-Modelle in die Irre führen. Um solche Angriffe abzuwehren, sollten Modelle auf ihre Robustheit gegen adversarial Beispiele getestet werden. Verschiedene Werkzeuge können helfen, Modelle zu härten, indem sie simulierte Angriffe durchführen und Schwachstellen aufzeigen.

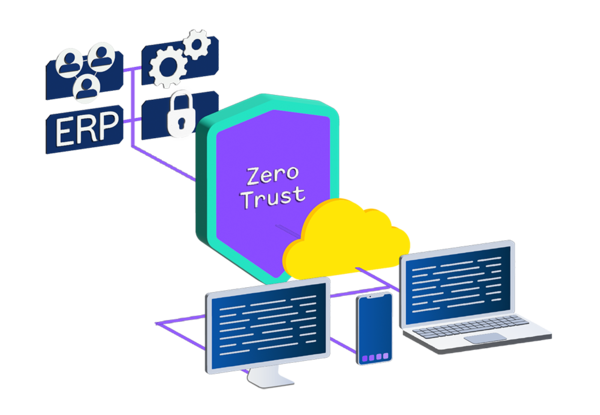

Sicherheitsarchitekturen und Zero Trust

Zero-Trust-Architekturen können helfen, den Zugriff auf KI-Modelle und deren Trainingsdaten zu kontrollieren. Bei Zero Trust wird jede Zugriffsanfrage auf Daten oder Anwendungen überprüft und validiert, so dass nur autorisierte Systeme und Benutzer Zugriff erhalten. Dies erschwert es Angreifern, in die Trainings- oder Produktionsumgebung von KI-Modellen einzudringen.

Whitepaper

Generative KI sicher integrieren

Die Hauptstärken von KI (oder auch AI, Artificial Intelligence) liegen in ihrer Fähigkeit, große Datenmengen zu analysieren, sich durch Lernprozesse anzupassen und auch komplexe Probleme zu lösen. Zunehmend trifft sie dabei selbstständig Entscheidungen und setzt diese um. Aber: Gerade durch den verstärkten Einsatz von KI in immer mehr Bereichen, gewinnt die AI Security zunehmend an Bedeutung. Traditionelle IT-Sicherheitsarchitekturen basieren häufig auf statischen Regeln, die bekannte Bedrohungen abwehren. Diese Systeme sind jedoch oft nicht in der Lage, sich an die dynamischen Prozesse rund um KI anzupassen.

Im Whitepaper “Kontrollierte Intelligenz” zeigen wir Ihnen einen Architekturvorschlag zum sicheren lokalen Betrieb generativer KI-Modelle in einem Zero-Trust-Netzwerk mit aktiver Traffic-Überwachung und mehrschichtiger Perimeterabsicherung durch Lösungen von genua auf.

Whitepaper

Wege zum sicheren Einsatz generativer KI in Unternehmen

Lösungen von genua zum Schutz Ihrer IT-Infrastruktur

Zuverlässiger Schutz für Netzwerke, Daten und kritische IT-Infrastrukturen

Tatsache ist, dass auch Angriffe mit Hilfe von KI-Systemen heute bereits an der Tagesordnung sind. genua bietet eine Reihe von spezialisierten Anwendungen und Lösungen im Bereich der IT-Sicherheit, mit denen Sie sich und Ihre IT-Infrastruktur vor KI-Angriffen schützen können. Diese Lösungen sind für Hochsicherheitsumgebungen konzipiert und konzentrieren sich insbesondere auf den Schutz von Netzwerken, Daten und kritischen IT-Infrastrukturen.

Absicherung mit KI

Wie wird KI als Werkzeug in der Cybersicherheit eingesetzt?

Viele moderne IT-Sicherheitsprodukte nutzen Künstliche Intelligenz, um Bedrohungen frühzeitig zu erkennen und zu neutralisieren. Dazu gehören Tools zur Anomalie-Erkennung und Authentifizierungsdienste. In diesen Systemen spielt maschinelles Lernen (engl.: machine learning), im folgenden ML, eine zentrale Rolle, um Muster zu analysieren und untypisches Verhalten zu erkennen, so dass potenzielle Bedrohungen identifiziert werden können, bevor sie Schaden anrichten. Auf diese Weise kann KI einen konsistenten und langfristigen Schutz von IT-Systemen bieten.

Was ist maschinelles Lernen?

Durch das Trainieren von Algorithmen mit historischen Daten (historical data) kann eine KI mittels ML lernen, was als normales Verhalten gilt. Dadurch ist KI in der Lage, Datenmuster zu erkennen, die von diesem Normalverhalten abweichen. Gerade die Erkennung von Anomalien wird in der Cybersicherheitsempfehlung des BSI (BSI-CS 134) als Mittel zum Schutz von Netzwerken besonders hervorgehoben. Durch die Analyse von (Verhaltens-)Mustern können ungewöhnliche Aktivitäten und Bedrohungen wie Cyberangriffe frühzeitig erkannt, Datenlecks aufgedeckt oder Systemausfälle verhindert werden. Im Rahmen der Netzwerküberwachung können beispielsweise ungewöhnlicher Datenverkehr oder ungewöhnliche Benutzeraktionen identifiziert oder Schadcode durch Antivirensoftware erkannt werden.

Im Gegensatz zu herkömmlichen Systemen, die auf signaturbasierten Ansätzen beruhen, lernen ML-Algorithmen kontinuierlich dazu und können Anomalien in Echtzeit erkennen. So können auch neue Bedrohungen, Stichwort Zero-Day-Exploits, abgewehrt werden.

Ein wichtiger Faktor bleibt die Sortierung und Priorisierung der Warnmeldungen. Diese Aufgabe ist besonders anfällig für Fehlklassifikationen. ML-Modelle verarbeiten dafür auch sehr große Datenmengen (Skalierbarkeit) und erkennen komplexe Zusammenhänge, die für menschliche Analystinnen und Analysten nicht unbedingt offensichtlich sind.

Was sind die Vorteile von maschinellem Lernen?

Durch kontinuierliches Lernen und Optimieren verbessern sich die ML-Modelle stetig, was zu einer geringeren Anzahl von False Positives führt. ML-Modelle können sich ohne manuelle Aktualisierung an veränderte Datenmuster anpassen und bleiben auch bei sich ändernden Bedrohungslandschaften oder neuen Verhaltensmustern wirksam. Weiterhin kann KI aus vorhandenen Daten künftige Bedrohungen vorhersagen und frühzeitig Schutzmaßnahmen einleiten, was die IT-Abteilungen erheblich entlastet.

Ein weiterer wichtiger Vorteil ist die Fähigkeit von KI, Prozesse zu automatisieren. Dabei geht es nicht nur darum, Angriffe in Echtzeit zu erkennen, sondern auch darauf zu reagieren. Sogenannte KI-Agenten, also autonome, selbstständig agierende KI, ermöglichen die automatische Erkennung und Beseitigung von Bedrohungen. Routineaufgaben wie Patch Management und Incident Response können automatisiert werden.

Sicherheit als integraler Bestandteil moderner IT

Neben dem gezielten Einsatz fortschrittlicher Technologien ist eine umfassende Beratung und Schulung unerlässlich. genua unterstützt Unternehmen bei der Implementierung von IT-Sicherheitslösungen und hilft ihnen, ihre IT-Sicherheit entscheidend zu erhöhen und Bedrohungen effektiv zu begegnen.

Automatisierung und intelligente Überwachung

Zero-Trust-Architekturen spielen eine wichtige Rolle für die IT-Sicherheit, erfordern jedoch ein hohes Maß an Überwachung und Datenverarbeitung. KI kann durch Automatisierung und intelligente Überwachung dabei helfen, potenzielle Bedrohungen in Echtzeit zu erkennen und den Zugang dynamisch zu verwalten. KI-Agenten können beispielsweise das Verhalten von Nutzern und Geräten analysieren. Erkennt die KI ungewöhnliche Zugriffszeiten oder verdächtige Datenmengen, kann sie in Echtzeit reagieren, indem sie den Zugriff automatisch einschränkt oder blockiert, zusätzliche Authentifizierungsmaßnahmen anfordert, betroffene Systeme unter Quarantäne stellt oder eine Tiefenanalyse durchführt. Darüber hinaus können sie selbstständig Gegenmaßnahmen einleiten und z.B. beschädigte oder infizierte Systeme ohne menschliches Zutun in einen sicheren Zustand zurückversetzen.

Wird KI in Authentifizierungs- und Zugangskontrollsysteme integriert, können bekannte Schwachstellen, wie rein passwortbasierte Lösungen überwunden werden. Dies verbessert die Genauigkeit und Zuverlässigkeit der Authentifizierung und erhöht die Sicherheit des Systems.

Der gezielte Einsatz von KI kann Unternehmen dabei helfen, Zeit und Ressourcen zu sparen, die Geschwindigkeit, mit der Unternehmen auf Bedrohungen reagieren, drastisch zu erhöhen und gleichzeitig das Risiko menschlicher Fehler zu reduzieren.

Was ist Retrieval-Augmented Generation?

Die Retrieval-Augmented Generation (RAG) ist eine der wichtigsten Anwendungen der KI. RAG ist ein erweitertes KI-System, das Informationen aus verschiedenen Datenquellen extrahieren und in die Generierung von Antworten einfließen lassen kann. Dabei verwendet es nicht nur die Trainingsdaten, sondern greift bei Bedarf auf verschiedene andere Quellen, z. B. Datenbanken einer Organisation, zu, um die Antworten zu verbessern oder Wissenslücken zu schließen. Auf diese Weise erweitert RAG die bereits leistungsfähigen Funktionen von LLMs (Large Languages Models), ohne dass das Modell neu trainiert werden muss.

Ein Beispiel: Ein Benutzer fragt nach einem bestimmten technischen Detail in einem Handbuch. Das RAG-System stellt daraufhin inhaltlich passende Textabschnitte aus seiner Dokumentendatenbank zusammen. Diese Daten werden zusammen mit der Frage des Nutzers an das KI-Modell übergeben, das daraus eine fundierte Antwort generiert. So können auch komplexe Fragen maßgeschneidert beantwortet und das Wissen dynamisch erweitert werden. Halluzinationen, also vom Modell selbst erfundene Antworten, werden effektiv reduziert.

Lassen Sie sich jetzt beraten

Sie interessieren sich für eine Beratung von unseren Experten, wie Sie Ihre eigene IT-Infrastruktur zuverlässig vor KI-Angriffen schützen können? Dann melden Sie sich jetzt!