Insights

Hoffnungsträger Artificial Intelligence

In Artificial Intelligence (AI) werden in der IT-Sicherheit viele Hoffnungen gesetzt, um die Komplexität zu reduzieren und Aufgaben zu automatisieren. AI macht aber auch Fehler und ist angreifbar – welche Erwartungen kann sie in sicherheitskritischen Bereichen erfüllen?

Vernetzte Computer spielen eine zunehmend kritische Rolle in unserem Leben. Entsprechend hohe Anforderungen zum Schutz von Daten und Verfügbarkeit werden an die Betreiber sensitiver Infrastrukturen gestellt. Diese können jedoch wegen der steigenden Komplexität der Netze, unzureichender Verfügbarkeit von kosteneffektiven Lösungen zum Management dieser Komplexität und wegen des Mangels an erfahrenem Personal im Bereich der IT-Sicherheit oft nicht erfüllt werden.

Von Artficial Intelligence wird in der IT Security erwartet, dass sie hochkomplexe Zusammenhänge automatisch erkennt, auf eine für den Menschen verständliche Komplexität reduziert sowie wiederkehrende Aufgaben weitgehend automatisiert ausführt. So soll die Produktivität des Fachpersonals gesteigert, das Einsatzspektrum weniger erfahrenen Personals erweitert wie auch schneller und präziser auf Gefahren reagiert werden können.

Klassische Herangehensweisen an AI in der IT-Sicherheit

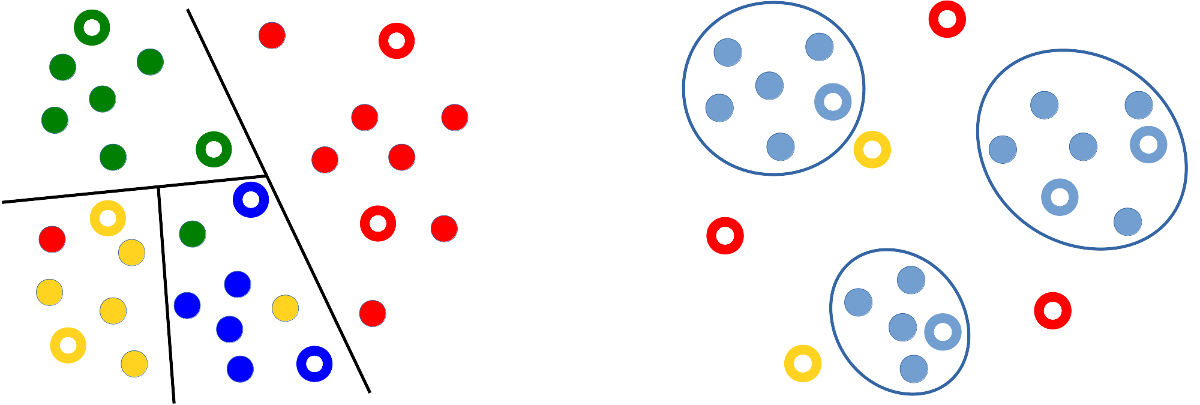

Zu den bekanntesten und ältesten Anwendungen von AI-Techniken in der IT-Sicherheit gehören Spam-Filter. Diese arbeiten typischerweise mit überwachtem (supervised) Lernen. Dabei wird ein Teil der Mails vom Menschen oder anhand externer Kriterien wie Blacklists explizit als Spam oder Ham markiert. Mittels AI wird daraus ein Datenmodell erstellt und dieses zur Klassifizierung unbekannter Mails als Spam oder Ham genutzt.

Ein klassisches Beispiel für unüberwachtes (unsupervised) Lernen wiederum ist die Anomalie-Erkennung: Hierbei wird ein Modell des aktuellen typischen Systemverhaltens gelernt und später auftretende Abweichungen davon als untypisch deklariert. Unüberwachtes Lernen wird weiterhin zum automatischen Clustering von Malware benutzt, um ähnliche Malware auf die wahrscheinlich gleichen Autoren zurückzuführen.

Herausforderungen für AI in der IT-Sicherheit

Die Anwendung von AI in der IT-Sicherheit bedeutet in vieler Hinsicht andere Herausforderungen als die Nutzung von AI z. B. in Empfehlungssystemen wie Spotify, der automatischen Kategorisierung von Bildern oder Sprachassistenten wie Siri oder Alexa. So hat man es in der IT-Sicherheit oftmals mit vergleichsweise wenig Daten zu tun, welche zusätzlich stark verzerrt sind und deren Charakteristika sich häufig ändern können.

Beispielsweise kommen selbst in einem größeren Unternehmen verhältnismäßig wenig Mails an, und von diesen stellt nur ein kleiner Bruchteil wirklich Angriffe da. Außerdem ändern sich über die Zeit sowohl die gutartigen E-Mails als auch das Vorgehen der Angreifer. In diesem Umfeld scheitern typische Big-Data-Methoden, bei denen Algorithmen komplexe Korrelationen finden, solange man ihnen nur genug Daten und genug Rechenzeit gibt. Menschliche Domain-Experten hingegen sind durch ihre fundierte Kenntnis des Problemfelds besser in der Lage, aus den Daten Merkmale zu generieren und zu kombinieren sowie auch bei wenigen und dynamischen Daten sinnvolle Ergebnisse zu erzielen.

Im Gegensatz zur Anwendung von AI in vielen anderen Bereichen muss in der IT-Sicherheit explizit davon ausgegangen werden, dass ein Angreifer versucht, inhärente Schwächen der Systeme zu erkennen und auszunutzen. Diese Schwächen existieren, weil ein AI-System basierend auf den Trainingsdaten nur Korrelationen und keine wirklichen Kausalzusammenhänge erlernt. So hatte z. B. ein Modell zur Analyse von PDF-Dateien aus den verfügbaren Trainingsdaten „gelernt“, dass bösartige PDFs typischerweise nur eine Seite haben. Damit reichte bereits das Hinzufügen einer weiteren Seite, um die Erkennung zu umgehen. Entsprechend sind erneut Domain-Experten gefragt, um die Merkmale und Modelle hinsichtlich Angreifbarkeit zu untersuchen und robustere Verfahren zu entwickeln. Zusätzlich kann versucht werden, den Zugriff des Angreifers auf die Modelle zu erschweren, z. B. durch kundenspezifische statt globale Modelle und durch die Beschränkung der Interaktionsmöglichkeiten des Angreifers mit den Modellen.

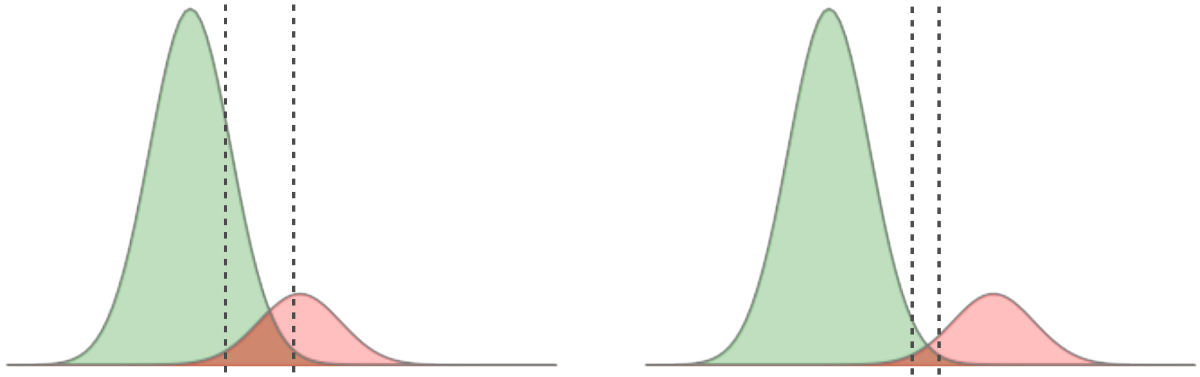

Und wie der Mensch, so ist auch AI nicht perfekt und macht Fehler. Dies sind eventuell aber andere Fehler, als sie ein Mensch machen würde und daher für diesen nicht verständlich und erwartbar. Solange AI-Systeme nur Empfehlungen geben, ist das nicht so schlimm. Kritischer wird es bei autonomen Entscheidungen. So kann es passieren, dass wichtige Mails abgelehnt und gefährliche Mails als gutartig markiert werden. Oder dass die Bewegungen eines Angreifers im Netz als normal gesehen, dagegen aber eine kritische, selten genutzte Datenverbindung blockiert wird. Entsprechend zurückhaltend ist man derzeit mit dem Einsatz autonom entscheidender AI-Systeme. Eine große Herausforderung ist daher die Entwicklung einer AI, deren Verhalten für den Menschen nachvollziehbar genug ist, dass er ihr für autonome Entscheidungen ausreichend vertraut. Dazu ist es wichtig zu verstehen, was eigentlich gelernt wurde, um auf dieser Basis Fehler im Modell korrigieren zu können.

AI bei genua

Die ersten Schritte mit AI haben wir bei genua im Forschungsprojekt Padiofire (2011–2013) gemacht, bei dem wir AI-Methoden zur Erkennung von eingeschleustem bösartigen JavaScript verwendet haben.

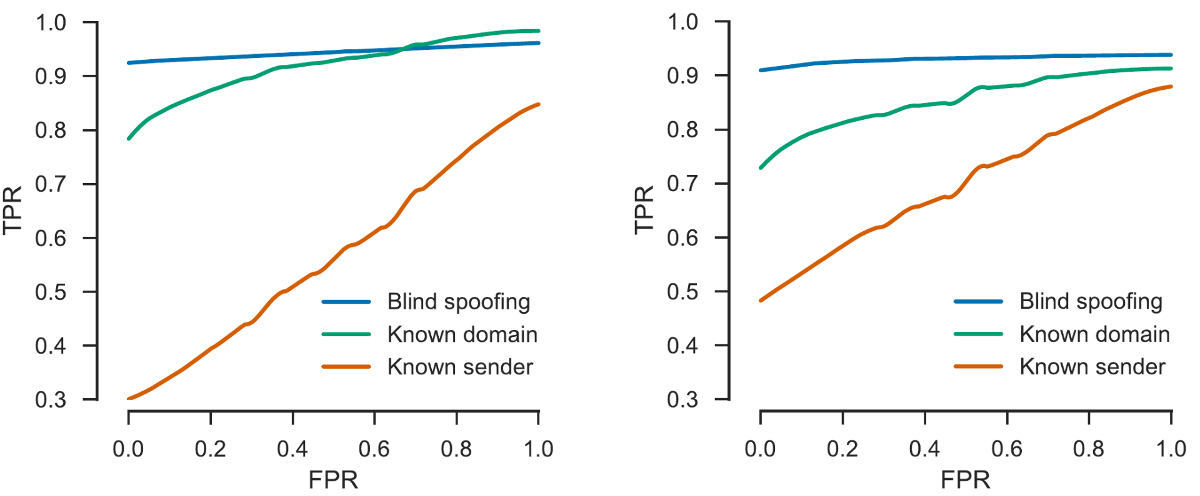

Im darauf folgenden Forschungsprojekt APT-Sweeper (2014–2018) haben wir uns mit der besseren Erkennung über Web und Mail erfolgender, gezielter Angriffe befasst. Dabei war AI die zentrale Technologie, um gefälschte Absender in Mails zu erkennen oder Phishing-Webseiten von gutartigen zu unterscheiden.

genua war in diesen vom Bundesministerium für Bildung und Forschung (BMBF) geförderten Projekten als Domain-Experte primär für Design und Extraktion von Merkmalen, eine Privacy-freundliche Datenerfassung und die Verifikation der Modelle in der Praxis zuständig und legte so die Grundlagen für die Erstellung leistungsfähiger Modelle durch die AI-Algorithmen.

Im Forschungsprojekt INDI (2014–2018) wiederum wurde AI zur Anomalie-Erkennung in Industrieprotokollen benutzt, wobei sich genua hier primär mit der garantiert nebenwirkungsfreien, sicheren Datenerfassung und -analyse in Industrienetzen befasste.

Zunehmend werden bei genua auch AI-Algorithmen selber angewendet, sowohl im Kontext von mehreren Bachelor- und Masterarbeiten als auch in Forschungsprojekten. So wurde z. B. im Kontext des Forschungsprojektes APT-Sweeper eine Masterarbeit zur intelligenteren Analyse von Mails durchgeführt, in der es uns durch den Einsatz von Artificial Intelligence gelungen ist, bisher unbekannte Variationen bösartiger Mails besser zu detektieren.

Aus unserer Sicht kann AI in der IT-Sicherheit viele der in sie gesetzten Hoffnungen erfüllen, sofern man sich der Probleme und Herausforderungen bewusst ist und diese gezielt angeht. Auch wenn keine Wunder zu erwarten sind, kann mittels AI die Komplexität reduziert und das Wissen einzelner Domain-Experten vielen Anwendern nutzbar gemacht werden. Deshalb haben wir uns auch am aktuellen Forschungsvorhaben „Artificial Intelligence für IT-Sicherheit“ des BMBF mit einem Forschungsantrag beteiligt und werden in naher Zukunft AI-Technologien zum Nutzen unserer Kunden in eigene Produkte integrieren.